Google Cloud宣布与AI初创公司Hugging Face展开合作,共同推动开源人工智能(AI)的发展。这一战略合作将允许开发者在无需支付Google Cloud订阅费用的情况下构建、训练和部署AI模型。利用Hugging Face平台的外部开发者将能够“高效”地访问Google的Tensor处理单元(TPU)和GPU超级计算机。这最终有望为开源社区带来实际利益。

声明中表示:“我们将与Google合作,跨足开放科学、开源技术、云计算和硬件领域,使企业能够利用Hugging Face的最新开源模型以及Google Cloud的最新云和硬件功能构建自己的AI。”

Hugging Face保存了一些已开源的基础模型,如Meta的Llama 2和Stability AI的Stable Diffusion。开发者可以像在GitHub上上传代码一样,操作和使用这些模型,成为受欢迎的AI模型仓库之一。此外,Hugging Face还提供了大量用于模型训练的数据库。

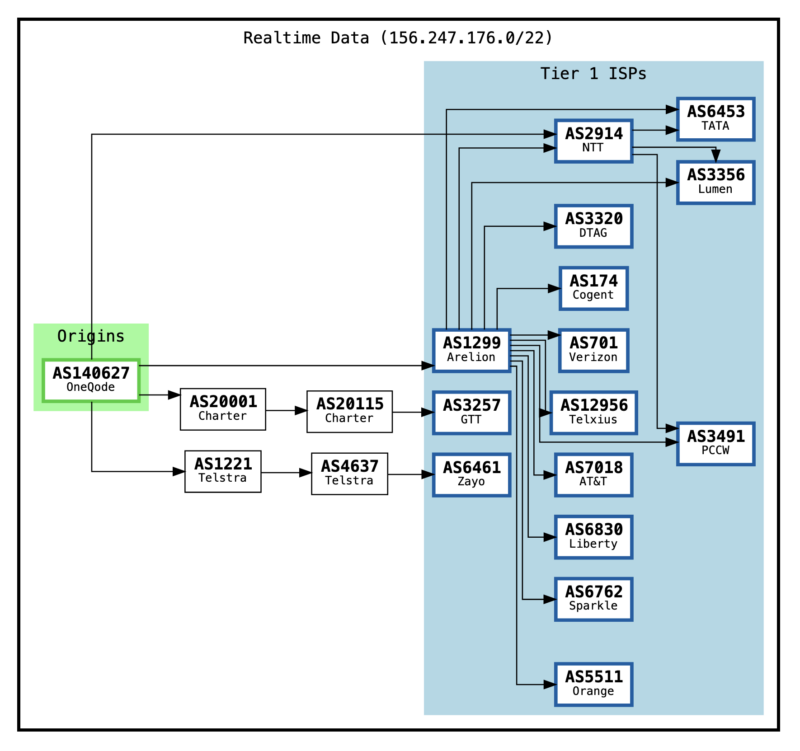

数十万Hugging Face用户已经在Google Cloud服务器上活跃。这一合作旨在使在Google Kubernetes Engine和Vertex AI内训练和托管新模型变得更加容易。

此次合作表明了对开源AI的进一步承诺,对于Google而言尤为重要。过去,Google一直依赖于自家项目和对Anthropic等的投资,过度依赖专有模型。

去年,Google的工程师表达了对公司在AI领域的开源开发者方面的滞后之虑。

关于Hugging Face

Hugging Face,成立于2016年,总部位于纽约,已经在开源AI社区中确立了重要地位,为开发者提供了一个重要的平台,用于共享和发展AI模型。

Hugging Face不仅与Google合作,还与其他主要技术公司建立了关系,扩大和改善了基础设施和服务。

例如,Hugging Face利用搭载其独有AI芯片Trainium的Amazon服务器,推动了开源语言模型Bloom的开发。与Nvidia的合作使Hugging Face用户可以利用NVIDIA的DGX云AI基础设施进行模型的训练和微调。

这些合作对于推动开源替代专有AI模型在全球范围内的普及至关重要。例如,尽管Hugging Face的HuggingChat是为了与OpenAI的ChatGPT竞争而设计的开源项目,但其成功尚未到来。修订版的Meta的LLaMa语言模型也可在Hugging Face找到。

您也可以联系文章作者本人进行修改,若内容侵权或非法,可以联系我们进行处理。

任何个人或组织,转载、发布本站文章到任何网站、书籍等各类媒体平台,必须在文末署名文章出处并链接到本站相应文章的URL地址。

本站文章如转载自其他网站,会在文末署名原文出处及原文URL的跳转链接,如有遗漏,烦请告知修正。

如若本站文章侵犯了原著者的合法权益,亦可联系我们进行处理。

![表情[xiaojiujie] - EVLIT](https://cdn.evlit.com/wp-content/themes/zibll/img/smilies/xiaojiujie.gif)

暂无评论内容