OpenAI成立了一个新团队,由其首席科学家和公司联合创始人之一Ilya Sutskever领导,旨在开发控制“超级智能”AI系统的方法。他们预测未来十年内可能出现超过人类智能的AI,并表示这种AI可能不仁慈,需要研究控制和限制它的方法。

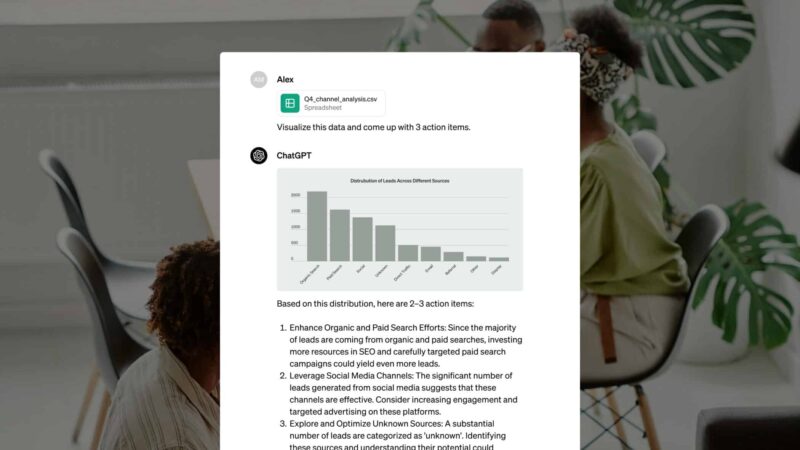

目前,对齐AI的技术依赖于人类监督AI的能力,但是人类无法可靠地监督比我们聪明得多的AI系统。为了解决这个问题,OpenAI正在创建一个新的超级对齐团队,旨在在未来四年内解决控制超级智能AI的核心技术挑战。该团队将与公司其他组织的研究人员一起,构建“人类级自动对齐研究员”,使用人类反馈训练AI系统,训练AI协助评估其他AI系统,并最终构建可以进行对齐研究的AI。

OpenAI的假设是,AI可以比人类更快地取得对齐研究进展。随着他们在这方面取得进展,AI系统可以接管越来越多的对齐工作,并最终构思、实施、研究和开发比现在更好的对齐技术。人类研究人员将更多地将精力集中在审核AI系统完成的对齐研究上,而不是自己生成这些研究。

当然,这种方法可能会存在不一致性、偏见或脆弱性,并且可能会发现对齐问题的最困难的部分与工程无关。但是Sutskever和Leike认为这是值得一试的。他们认为,超级智能对齐基本上是一个机器学习问题,伟大的机器学习专家将是解决问题的关键。他们计划广泛分享这一努力的成果,并将为非OpenAI模型的对齐和安全做出贡献视为他们工作的重要组成部分。

© 版权声明

本站所有文章,仅代表文章作者个人观点,如对观点有疑义时不用怀疑,您绝对是对的。

您也可以联系文章作者本人进行修改,若内容侵权或非法,可以联系我们进行处理。

任何个人或组织,转载、发布本站文章到任何网站、书籍等各类媒体平台,必须在文末署名文章出处并链接到本站相应文章的URL地址。

本站文章如转载自其他网站,会在文末署名原文出处及原文URL的跳转链接,如有遗漏,烦请告知修正。

如若本站文章侵犯了原著者的合法权益,亦可联系我们进行处理。

您也可以联系文章作者本人进行修改,若内容侵权或非法,可以联系我们进行处理。

任何个人或组织,转载、发布本站文章到任何网站、书籍等各类媒体平台,必须在文末署名文章出处并链接到本站相应文章的URL地址。

本站文章如转载自其他网站,会在文末署名原文出处及原文URL的跳转链接,如有遗漏,烦请告知修正。

如若本站文章侵犯了原著者的合法权益,亦可联系我们进行处理。

THE END

![表情[xiaojiujie] - EVLIT](https://cdn.evlit.com/wp-content/themes/zibll/img/smilies/xiaojiujie.gif)

暂无评论内容