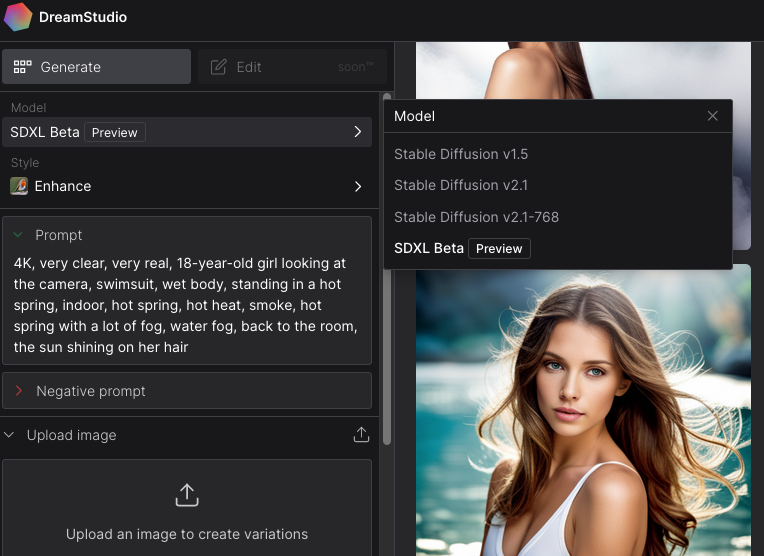

Stable Diffusion和DALL·E等扩散模型在图像、音频和视频生成方面表现出优异的能力。但是扩散模型是以牺牲GPU性能作为代价的,它的迭代采样过程需要10到2000倍于传统单步(one-step)生成模型,需要藉由对抗网络(GAN)等的计算量进行对抗训练,以逐步消除噪声并产成高质量的输出。而Consistency Models是可以支持快速 one-step 生成,同时仍然允许少量步数(few-step)采样,以权衡计算量和采样质量。另外Consistency Models还支持零样本(zero-shot)的数据编辑,无需进行对抗训练就可以执行例如图像修复、着色和超分辨率等任务。Consistency Models 可以用蒸馏预训练扩散模型的方式进行训练,也可以作为独立的生成模型进行训练。

接下来将引述OpenAI的研究团队的论文,详细阐述一下Consistency Models是如何做到一秒18张出图的。

正文开始

OpenAI的研究团队的新论文“Consistency Models”中介绍了一种非常高效的生成模型,即Consistency Models,它可以在没有对抗训练的情况下实现单步(single-step或one-step)样本生成模型。

Consistency Models 作为一种生成模型,核心设计思想是支持 single-step 生成,同时仍然允许迭代生成,支持零样本(zero-shot)数据编辑,权衡了样本质量与计算量。

首先 Consistency Models 建立在连续时间扩散模型中的概率流 (PF) 常微分方程 (ODE) 之上。如下图 1 所示,给定一个将数据平滑地转换为噪声的 PF ODE,Consistency Models 可以学习将任意时间步(time step)的任意点映射成轨迹起点,并进行生成建模。因此,Consistency Models 有一个显著的特性是自洽性(self-consistency):同一轨迹上的点会映射到相同的初始点。这也是模型被命名为 Consistency Models(一致性模型)的原因。

![图片[1] - OpenAI新模型:研究论文告诉你 Consistency Models 是如何做到 一步成图,1秒18张 - EVLIT](https://imgcache.evlit.com/wp-content/uploads/2023/04/5690f30518aed20c15d258d348f50aa2.webp)

研究人员介绍了 Consistency Models 两种基于自洽性的训练方法。第一种训练方法是评估转换随机噪声向量(ODE 轨迹的端点,例如图 1 中的 x_T)来生成数据样本(ODE 轨迹的初始点,例如图 1 中的 x_0),并将扩散模型进行有效提取迭代优化,从而提高了样本质量,以更多计算为代价执行零样本数据编辑操作。

![图片[2] - OpenAI新模型:研究论文告诉你 Consistency Models 是如何做到 一步成图,1秒18张 - EVLIT](https://imgcache.evlit.com/wp-content/uploads/2023/04/83b14fefbe186201e0a3685a14847236.webp)

第二种方法则是独立进行训练,不依赖于预先训练的扩散模型,从而建立Consistency Models作为独立的生成模型系列的基石。

需要注意的地方是,这两种训练方法都不需要对抗训练,并且都允许 Consistency Models 灵活采用神经网络架构。

![图片[3] - OpenAI新模型:研究论文告诉你 Consistency Models 是如何做到 一步成图,1秒18张 - EVLIT](https://imgcache.evlit.com/wp-content/uploads/2023/04/81970de6fcae212f6a87fae5a0b53c21.webp)

实证研究

在实证研究中,研究人员将Consistency Models应用于实际图像数据集,包括CIFAR-10、ImageNet 64×64、LSUN Bedroom 256×256和LSUN Cat 256×256。实验表明,通过Consistency Models的提取,CIFAR-10的单步生成达到了3.55的最新FID分数,ImageNet 64×64的单步生成达到了6.20的FID分数,甚至单独的Consistency Models也比现有的单步非逆生成模型更加优秀。

论文证明了所提出的Consistency Models可以在进行单步生成的同时实现更加高效的采样。但由于这项研究仍处于早期阶段,因此无法直接与扩散模型进行比较。期待后续能有重大的进展吧!

您也可以联系文章作者本人进行修改,若内容侵权或非法,可以联系我们进行处理。

任何个人或组织,转载、发布本站文章到任何网站、书籍等各类媒体平台,必须在文末署名文章出处并链接到本站相应文章的URL地址。

本站文章如转载自其他网站,会在文末署名原文出处及原文URL的跳转链接,如有遗漏,烦请告知修正。

如若本站文章侵犯了原著者的合法权益,亦可联系我们进行处理。

![[Copilot体验篇] 如何启用 Microsoft Copilot for Word - EVLIT](https://imgcache.evlit.com/wp-content/uploads/2023/03/5d2592e8bab5112c7d161e133eade524.png)

hi6天前0

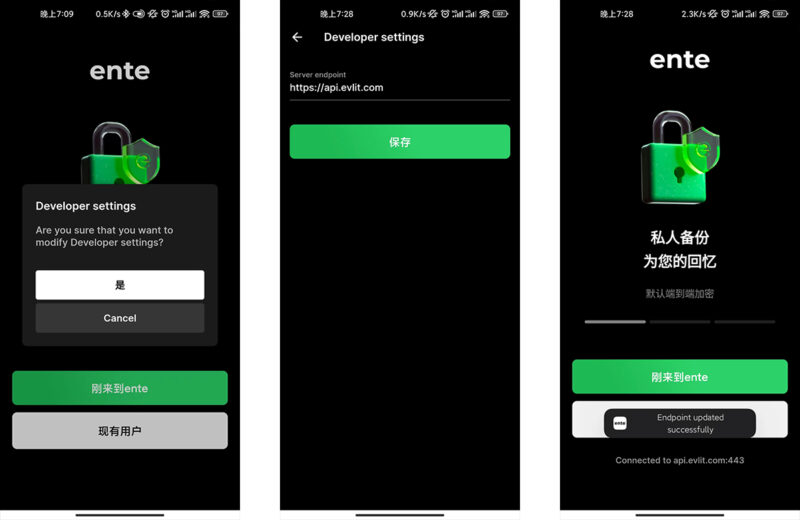

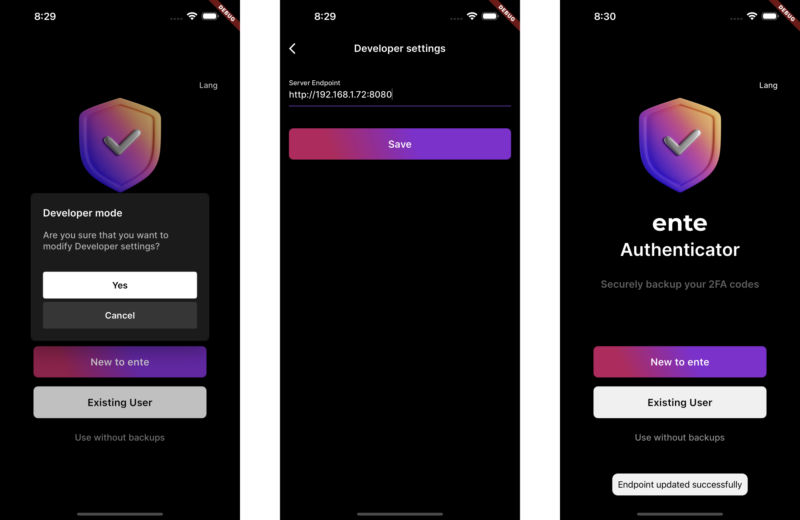

请问有详细一点的自己搭建的教程吗你好15天前0

你好,可以再帮我看看吗? 我已经按照你的方法设定了,还是一样,wordpress后台的 Purge Varnish Cache 插件还是清除不到cache,依旧显示 the varnish control terminal is not responding at。谢谢 https://mjj.today/i/Srk2Tz https://mjj.today/i/Srkcoi你好17天前0

对,你说的没错,我配置的时候改了一些东西,现在我按照你的教学,可以启动了,网页可以缓存了,不过wordpress 清除cache 那个插件没用的,我输入本地回环地址127.0.0.1 :6082 ,再输入API key ,插件显示the varnish control terminal is not responding at 127.0.0.1:6082,就你图片那样,然后试一下点击清除cache 那里,他显示error,研究了一天,还是没有不行。你好19天前1

你好,为啥我按照你的方法,到第三部分,去到真正后源的服务器设定Varnish 部分,我填了真正后源的IP跟端口跟域名,然后重启 Varnish ,就出现这样了? 这是怎么回事? 谢谢 [Linux] AMH 7.1 https://amh.sh [varnish-6.6 start] ================================================== =========== [OK] varnish-6.6 is already installed. Could not delete 'vcl_boot.1713549650.959259/vgc.sym': No such file or directory Error: Message from VCC-compiler: VCL version declaration missing Update your VCL to Version 4 syntax, and add vcl 4.1; on the first line of the VCL files. ('/home/usrdata/varnish/default.conf' Line 1 Pos 1) ... #--- Running VCC-compiler failed, exited with 2 VCL compilation failedchu31天前0

很完善的教程‘hu36天前0

我用gmail EMAIL_SERVER="smtp://********@gmail.com:bpyfv*********[email protected]:587"叽喳36天前0

MAIL_SERVER="smtp://[email protected]:[email protected]:587" 大佬 这个使用outlook 或者gmail 是什么样子的格式? 邮寄已经开启smtp了hu37天前0

输入框的问题解决了,我没有设置反代,NEXTAUTH_URL改为域名+端口就好了