周一,来自微软的研究人员介绍了Kosmos-1,一个多模态模型,可以分析图像内容,解决视觉难题,进行视觉文本识别,通过视觉智商测试,并理解自然语言指令。研究人员认为多模态人工智能–它整合了不同的输入模式,如文本、音频、图像和视频–是建立人工通用智能(AGI)的关键步骤,可以执行人类水平的一般任务。

研究人员在他们的学术论文《语言不是你的全部》中写道:”作为智能的一个基本部分,多模态感知是实现人工通用智能的一个必要条件,在知识获取和立足于现实世界方面,将感知与语言模型结合起来。”

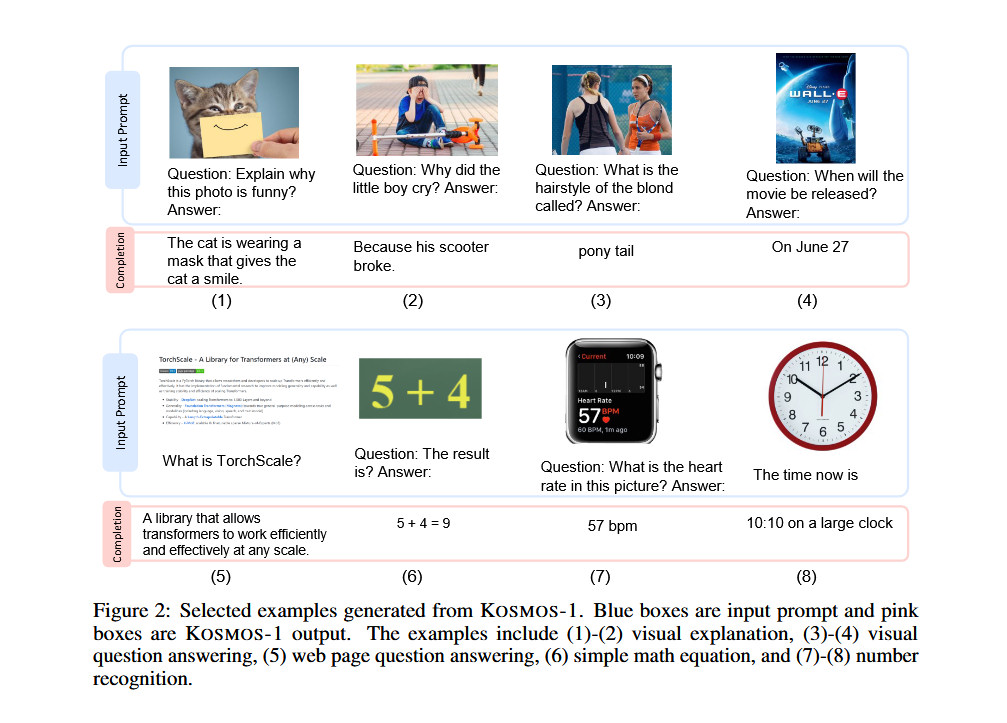

Kosmos-1论文中的视觉案例显示,该模型分析图像并回答有关问题,从图像中阅读文本,为图像编写标题,并以22-26%的准确率进行视觉智商测试。

当媒体热议大型语言模型(LLM)的突破时,一些人工智能专家指出,多模态人工智能是通往通用人工智能的潜在途径,这种假想的技术表面上将能够在任何智力任务(和任何智力工作)中取代人类。AGI是OpenAI的既定目标,它是微软在人工智能领域的一个重要商业伙伴。

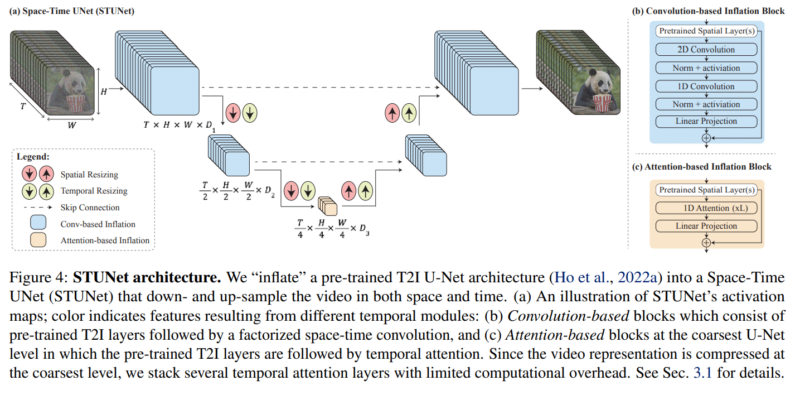

在这种情况下,Kosmos-1似乎是一个没有OpenAI参与的微软公司内部项目。研究人员将他们的创造称为”多模态大语言模型”(MLLM),因为它的根源在于自然语言处理,就像纯文本的LLM,如ChatGPT就是其中的杰出代表。为了让Kosmos-1接受图像输入,研究人员必须首先将图像翻译成LLM能够理解的一系列特殊标记(基本上是文本)。Kosmos-1的论文对此有更详细的描述:

对于输入格式,我们将输入平铺为一个用特殊标记物装饰的序列。具体来说,我们使用和来表示序列的开始和结束。特殊标记和表示编码后的图像嵌入的开始和结束。

例如,"document"是一个文本输入,而"Image Embedding paragraph "是一个交错的图像-文本输入。

一个嵌入模块被用来将文本标记和其他输入模式都编码为向量。然后,嵌入被送入解码器。对于输入标记,我们使用一个查找表将其映射到嵌入中。对于连续信号的模态(如图像和音频),将输入表示为离散代码,然后将其视为"外语"也是可行的。

微软使用网络上的数据训练Kosmos-1,包括The Pile(800GB的英文文本资源)和Common Crawl的节选。训练结束后,他们在一些测试中评估了Kosmos-1的能力,包括语言理解、语言生成、无光学字符识别的文本分类、图像说明、视觉问题回答、网页问题回答和零拍图像分类。据微软称,在许多这些测试中,Kosmos-1的表现超过了目前最先进的模型。

Kosmos-1负责解决的瑞文智商测试的一个例子

特别令人感兴趣的是Kosmos-1在瑞文推理中的表现,该测试通过展示一连串的形状并要求测试者完成该序列来测量视觉智商。为了测试Kosmos-1,研究人员将一个个填写好的测试题输入,每次完成每个选项,并询问答案是否正确。Kosmos-1只能在22%的时间内正确回答瑞文测试中的问题(微调后为26%),方法上的错误可能会影响结果,但Kosmos-1在拉文智商测试中击败了随机机会(17%)。

尽管如此,虽然Kosmos-1代表了多模态领域的早期步骤(其他厂商也在追求这种方法),但很容易想象,未来的优化可能会带来更重要的结果,使人工智能模型能够感知任何形式的媒体并对其采取行动,这将大大增强人工助理的能力。研究人员说,在未来,他们希望扩大Kosmos-1的模型规模,并将语音能力也整合进去。

微软表示,它计划将Kosmos-1提供给开发者,尽管该论文引用的GitHub页面在本文发表时还没有提供Kosmos特定代码。

原文链接: 微软公布新人工智能模型Kosmos-1:了解图像内容、解决视觉难题 – Microsoft 微软 – cnBeta.COM

您也可以联系文章作者本人进行修改,若内容侵权或非法,可以联系我们进行处理。

任何个人或组织,转载、发布本站文章到任何网站、书籍等各类媒体平台,必须在文末署名文章出处并链接到本站相应文章的URL地址。

本站文章如转载自其他网站,会在文末署名原文出处及原文URL的跳转链接,如有遗漏,烦请告知修正。

如若本站文章侵犯了原著者的合法权益,亦可联系我们进行处理。

你好昨天0

你好,可以再帮我看看吗? 我已经按照你的方法设定了,还是一样,wordpress后台的 Purge Varnish Cache 插件还是清除不到cache,依旧显示 the varnish control terminal is not responding at。谢谢 https://mjj.today/i/Srk2Tz https://mjj.today/i/Srkcoi你好3天前0

对,你说的没错,我配置的时候改了一些东西,现在我按照你的教学,可以启动了,网页可以缓存了,不过wordpress 清除cache 那个插件没用的,我输入本地回环地址127.0.0.1 :6082 ,再输入API key ,插件显示the varnish control terminal is not responding at 127.0.0.1:6082,就你图片那样,然后试一下点击清除cache 那里,他显示error,研究了一天,还是没有不行。你好5天前1

你好,为啥我按照你的方法,到第三部分,去到真正后源的服务器设定Varnish 部分,我填了真正后源的IP跟端口跟域名,然后重启 Varnish ,就出现这样了? 这是怎么回事? 谢谢 [Linux] AMH 7.1 https://amh.sh [varnish-6.6 start] ================================================== =========== [OK] varnish-6.6 is already installed. Could not delete 'vcl_boot.1713549650.959259/vgc.sym': No such file or directory Error: Message from VCC-compiler: VCL version declaration missing Update your VCL to Version 4 syntax, and add vcl 4.1; on the first line of the VCL files. ('/home/usrdata/varnish/default.conf' Line 1 Pos 1) ... #--- Running VCC-compiler failed, exited with 2 VCL compilation failedchu17天前0

很完善的教程‘hu22天前0

我用gmail EMAIL_SERVER="smtp://********@gmail.com:bpyfv*********[email protected]:587"叽喳22天前0

MAIL_SERVER="smtp://[email protected]:[email protected]:587" 大佬 这个使用outlook 或者gmail 是什么样子的格式? 邮寄已经开启smtp了hu23天前0

输入框的问题解决了,我没有设置反代,NEXTAUTH_URL改为域名+端口就好了hu23天前0

后面搭好了,但是不配置umami的话,进去之后保存按钮点不了,而且转发设置了都不通 又重新搭之后注册界面输入框没了