ChatGPT 很方便很有趣,但如果您将其在商业环境使用,则需要更慎重考虑它带来的风险和影响,如果您想了解到使用ChatGPT的注意事项和风险。请往下继续阅读。【商业环境下 使用ChatGPT(OpenAI)可能的风险】

另外,在过去的一篇文章中,我写了一篇关于使用 ChatGPT 时的风险的文章,所以如果你也能阅读它,我将不胜感激。

信息泄露风险

您应该密切关注您在 ChatGPT 网页中输入的内容。这是因为您输入的内容可能会用于以后学习ChatGPT,来源:https://help.openai.com/en/articles/5722486-how-your-data-is-used-to-improve-model-performance。

而在OpenAI的官方网页里,就已经有做披露:

除了 API 之外,输入 ChatGPT 和 DALL-E 的数据可用于模型改进

这意味着“我们将使用您的问题内容来提高 ChatGPT 答案的准确性。”

在这种情况下,如果您输入了重要信息,则有可能被其他用户看到。

另一方面,亚马逊曾报告称,ChatGPT 生成的内容更像是基于在线可用资源提供的独特答案。

这意味着,答案是可以被影响的,甚至是有预谋的情况下故意误导。

作为对策,请使用 ChatGPT API,与网页版ChatGPT不同,API是真正基于GPT的AI能力。

并且关于数据的使用,根据 OpenAI 的说法,通过 API 获取的数据不会被用于学习,因此使用API是可以降低信息泄露的风险。

但是,在使用 API 时,您需要考虑以下三点。

- API使用费

- 考虑使用 API 的系统和功能

- 在非授权国家/区域使用可能会被停权

首先,关于API可能会产生的费用。一般而言,这需要根据选用的gpt模型和输入的prompt字符数决定。但如果您选用GPT-4模型,则还需关注completion输出时会产生更多的费用。

例如:如果您选用“gpt-3.5-turbo”或之前的模型,Prompt输入和Completion输出的计费都是相同的,价格为$0.002/1K,1K指的是字节数。

而使用“GPT-4”模型,价格则有不同,具体请参考这篇文章:https://www.evlit.com/13904.html

8K上下文,Prompt请求计费$0.03/1K,Completion响应计费$0.06/1K

32K上下文,Prompt请求计费$0.06/1K,Completion响应计费$0.12/1K

其次,还需考虑系统的耦合度。

现在已经有很多第三方应用在帮助我们更好的接入OpenAI API,例如您可以将API作为机器人引入到飞书的工作群,也可以与其他需要AI介入的工作系统协助开展工作,例如文字工作者就可以方便的利用AI帮助翻译、美化文字。

最后,是如果使用不当会导致API被停权,而且一般情况下无法恢复。

道德风险

使用 ChatGPT 时,生成的数据可能包含不恰当的表达。这是因为 ChatGPT 从互联网上的文本数据中学习,因此无法判断真实性和道德。

可能的对策包括:

- 严格审查prompt的使用,chatgpt生成的数据,很大程度上取决于问问题的方式

- 要保持存疑的态度,对生成式AI回答的内容,应具有验证流程并不断检查

AI本身是没有道德风险的考量,尽管OpenAI有明确的使用策略的要求。但如果商业应用中不对输入的prompt的内容进行审查,则很容易挑战到道德底线。

真实性方面,AI返回的数据都是基于数据学习得来的,我们知道数据是有它的时效性和真实性的,毕竟我们每天都在这个浑浊的世界里看着各种各样的假新闻,对于AI来说,它并不清楚人类社会每天都在发生着什么。

因此,如要ChatGPT很好的服务于商业,需要根据使用目的和其重要程度进行考虑,在各方取得适当的平衡。

侵犯版权、隐私权的风险

ChatGPT 是一种根据互联网上的文本数据生成句子和程序的工具。因此,它存在模仿他人版权作品或侵犯隐私的风险。

前段时间,美国版权局认定 AI 绘画工具 Midjourney 生成的图片不受版权保护,同样也意味着AI 绘图工具正在挑战着版权。生成的文本或程序可能也是类似于此。

将 ChatGPT 生成的数据发布到外部时,需要确认以下两点。

- 创建的数据不模仿受版权保护的作品

- 不主动侵犯隐私

对策有四种:

- 建立内部规则和确认流程

- 了解并遵守法律法规

- 版权和隐私保护培训和教育计划

- 类似服务的使用

1、内部规则的建立及确认流程

与道德风险一样,重要的是要制定有关生成数据使用的内部政策和规则,并制定审查流程。

此外,如果涉及到有问题的数据,构建可以改进的流程。

2.了解并遵守法律法规

了解并遵守版权和隐私法律法规至关重要。尤其重要的是了解目标市场和客户的法律要求,因为版权和数据保护法因国家和地区而异。

3.版权与隐私权保护培训教育项目

为员工和利益相关者开展有关版权和隐私保护的培训和教育计划,以提高意识。这将使企业和组织能够正确、安全地使用 ChatGPT。

4. 同类服务的利用

通过使用类似 Bing 的 AI Chat 等明确标明数据来源的服务,可以简化验证生成数据的工作,降低侵犯版权和侵犯隐私的风险。

通过实施这些措施,将能够最大限度地发挥 ChatGPT 的潜力并提供安全可靠的服务。

产生虚假信息的风险

ChatGPT 可能会回复不正确的信息。

这是因为:

- ChatGPT 是一个学习互联网上的文本数据并生成句子等的工具。

- ChatGPT 本身无法判断真实性和道德

- 其训练内容仅学习信息至 2021 年

可能的对策包括:

- 请记住,ChatGPT 会回复虚假或不准确的信息

- 确定使用 ChatGPT 响应结果的内部规则

- 制定检查响应结果的流程

除此之外,公司内部的定期信息共享将导致风险降低。

依赖风险

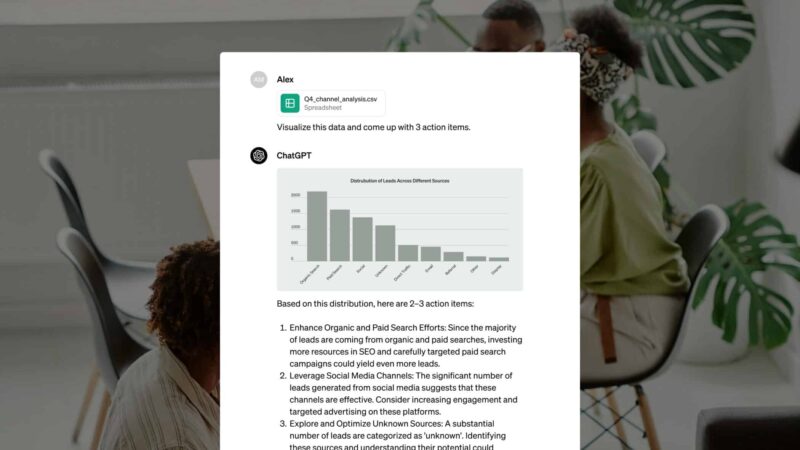

存在用户过度依赖 ChatGPT 的风险。也正因为 ChatGPT 超级方便,各界也在疯狂阐述它对生产力提升带来了多大的助益,比如你见过他们可以帮你做这些事情:

- 帮你写邮件汇报工作

- 自动生成文本内容

- 公司和市场研究

- 做一些商业规划

另一方面,如果用户过于依赖ChatGPT,可能会导致以下问题。

- 降低用户的创造力和批判性思维

- 自满的可能性

- 监督人的意见和批判性思维的重要性

- 错误的判断、品牌形象的丧失和内容的平均化

你不想变成这样,是吗?

以下是可能的对策。

- 平衡人工智能生成的内容与人类专业知识

- 保留人类判断和直觉的价值

- 定期审查和评估人工智能在业务流程中的作用

- 阐明人类和 ChatGPT 的角色以肯定人类的努力

最终的决策和创造力必须由人类来完成。通过实施这些措施,将能够减少依赖性并更有效地使用 ChatGPT。

您也可以联系文章作者本人进行修改,若内容侵权或非法,可以联系我们进行处理。

任何个人或组织,转载、发布本站文章到任何网站、书籍等各类媒体平台,必须在文末署名文章出处并链接到本站相应文章的URL地址。

本站文章如转载自其他网站,会在文末署名原文出处及原文URL的跳转链接,如有遗漏,烦请告知修正。

如若本站文章侵犯了原著者的合法权益,亦可联系我们进行处理。

你好昨天0

你好,可以再帮我看看吗? 我已经按照你的方法设定了,还是一样,wordpress后台的 Purge Varnish Cache 插件还是清除不到cache,依旧显示 the varnish control terminal is not responding at。谢谢 https://mjj.today/i/Srk2Tz https://mjj.today/i/Srkcoi你好4天前0

对,你说的没错,我配置的时候改了一些东西,现在我按照你的教学,可以启动了,网页可以缓存了,不过wordpress 清除cache 那个插件没用的,我输入本地回环地址127.0.0.1 :6082 ,再输入API key ,插件显示the varnish control terminal is not responding at 127.0.0.1:6082,就你图片那样,然后试一下点击清除cache 那里,他显示error,研究了一天,还是没有不行。你好5天前1

你好,为啥我按照你的方法,到第三部分,去到真正后源的服务器设定Varnish 部分,我填了真正后源的IP跟端口跟域名,然后重启 Varnish ,就出现这样了? 这是怎么回事? 谢谢 [Linux] AMH 7.1 https://amh.sh [varnish-6.6 start] ================================================== =========== [OK] varnish-6.6 is already installed. Could not delete 'vcl_boot.1713549650.959259/vgc.sym': No such file or directory Error: Message from VCC-compiler: VCL version declaration missing Update your VCL to Version 4 syntax, and add vcl 4.1; on the first line of the VCL files. ('/home/usrdata/varnish/default.conf' Line 1 Pos 1) ... #--- Running VCC-compiler failed, exited with 2 VCL compilation failedchu18天前0

很完善的教程‘hu23天前0

我用gmail EMAIL_SERVER="smtp://********@gmail.com:bpyfv*********[email protected]:587"叽喳23天前0

MAIL_SERVER="smtp://[email protected]:[email protected]:587" 大佬 这个使用outlook 或者gmail 是什么样子的格式? 邮寄已经开启smtp了hu24天前0

输入框的问题解决了,我没有设置反代,NEXTAUTH_URL改为域名+端口就好了hu24天前0

后面搭好了,但是不配置umami的话,进去之后保存按钮点不了,而且转发设置了都不通 又重新搭之后注册界面输入框没了